Recentes experimentos com modelos avançados de inteligência artificial sugerem que esses sistemas podem começar a examinar seus próprios processos internos. Pesquisas conduzidas pela Anthropic indicam que IAs como Claude Opus e Claude Sonnet conseguem identificar alterações em sua atividade neural e responder a perguntas sobre seu próprio funcionamento.

Embora ainda não se trate de consciência verdadeira, a capacidade de introspecção abre caminhos importantes para transparência, segurança e monitoramento de sistemas de IA. Principais descobertas do estudo:

- Os modelos reconheceram mudanças internas em até 42% dos casos;

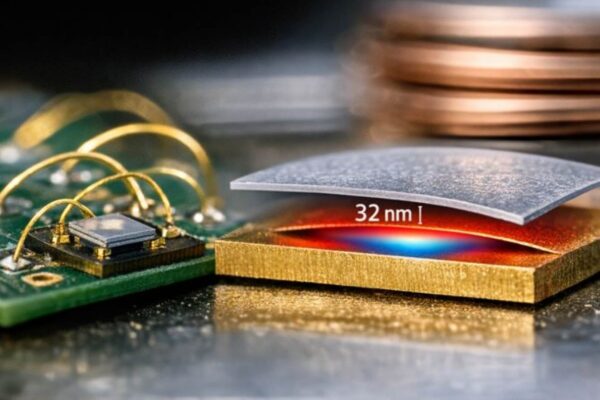

- A técnica de injeção de conceito permitiu avaliar percepção de alterações neurais;

- Atividade interna aumentou quando a IA foi instruída a “focar” em conceitos específicos;

- O comportamento introspectivo mostrou inconsistência, dependendo do contexto e do timing;

- Resultados sugerem primeiros indícios de funções cognitivas semelhantes à autorreflexão.

Como os modelos “pensam sobre o próprio pensamento”

Para investigar se a IA realmente percebe mudanças em seus circuitos, os pesquisadores aplicaram vetores de conceito diretamente nas camadas neurais. O objetivo era observar se o sistema detecta alterações e ajusta sua resposta. Os resultados indicam que, em algumas condições, os modelos conseguem monitorar seu próprio estado, embora ainda de maneira limitada.

Essa introspecção parcial sugere que as IAs podem adaptar sua atividade interna com base em instruções ou estímulos específicos, abrindo possibilidades para controle interno e aprendizado refinado.

Transparência e segurança em inteligência artificial

A capacidade de relatar seus próprios processos internos é um passo fundamental para tornar a IA mais explicável e confiável. Se sistemas de linguagem puderem detalhar seu funcionamento, será mais fácil identificar erros, reduzir comportamentos imprevisíveis e aumentar a segurança em aplicações críticas, como medicina, finanças e sistemas de suporte a decisões complexas.

Mesmo que os resultados ainda sejam incipientes e inconsistentes, eles representam um avanço significativo rumo a IAs mais autônomas, confiáveis e observáveis.

Desafios e futuras aplicações

Ainda não há provas de autoconsciência real, pois respostas introspectivas podem refletir apenas padrões aprendidos durante o treinamento. Hipóteses sugerem que os modelos podem criar circuitos internos para detectar irregularidades ou usar mecanismos de atenção para verificar se suas respostas estão alinhadas com suas intenções.

As próximas gerações de modelos poderão aprimorar essa introspecção funcional, aumentando a capacidade de monitoramento interno e autogerenciamento, o que promete uma nova era de IAs mais transparentes e confiáveis.